Von WordPress zu Hugo: Warum wir unsere Website migriert haben

Wir haben unsere Website von WordPress auf Hugo umgestellt. In diesem Artikel erklären wir, warum wir diesen Schritt …

Entfesseln Sie Ihr Geschäftspotenzial mit Nines Anwendungs- und Plattform-Management. Von Experten verwaltet, für Ihren Erfolg konzipiert.

Wir kümmern uns um all Ihre Anwendungen und Plattformen, indem wir sie ständig überwachen.

All unsere Produkte und Services können auf Ihre individuellen Bedürfnisse zugeschnitten werden.

Wir kümmern uns um alle notwendigen Arbeiten, damit Sie sich auf Ihre Stärken konzentrieren können.

Als Schweizer Cloud Provider sorgen wir dafür, dass all Ihre Instanzen permanent verfügbar sind. Ausserdem überprüfen wir Ihre Anwendungen auf einen reibungslosen Betrieb. Wenn etwas passiert, informieren wir Sie sofort und beteiligen uns aktiv an der Behebung von Fehlern.

Vom traditionellen Hosting bis hin zu DevOps – wir machen alles, wenn's um Schweizer Cloud Services geht. Neben Colocation, Managed Hosting und vielem mehr bieten wir zum Beispiel auch Container-Plattformen und unsere neue App-Engine Deploio an.

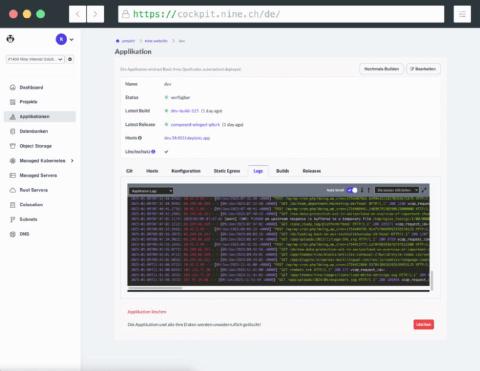

Unser Cockpit ermöglicht es Ihnen, viele Nine-Produkte an einem Ort zu verwalten. Sie haben die Kontrolle – passen Sie Ihre Produkte und Dienstleistungen an, erweitern Sie sie mit zusätzlichen Tools oder finden Sie Lösungen für Ihre Fragen.

Wir verwalten nicht nur Ihren Kubernetes-Cluster, sondern bieten einen …

Sie möchten Ihre Website und Anwendungen erfolgreich betreiben, ohne sich um die …

Als zukunftsweisende App-Engine vereinfachen wir den Einsatz und die Verwaltung …

Mit unseren Root Dedicated Servern profitieren Sie von unserer leistungsfähigen …

Sie möchten ein Large Language Model (LLM) betreiben, das mit menschlicher …

Was auch immer Sie für eine Datenbank suchen, wir haben sie. Benötigen Sie eine …

Ein Service Level Agreement (SLA) regelt wiederkehrende Leistungen sowie den …

Unser S3-kompatibler Object Storage passt sich kontinuierlich an Ihren …

Ihre eigene Hardware soll sicher untergebracht werden und in guten Händen sein, …

Unter Caching versteht man das Speichern von Daten an einem temporären Ort – …

Sie möchten die Benutzerauthentifizierung und -autorisierung mit Shibboleth …

Solr ist die ideale Ergänzung zum eigenen Content-Management-System: Es kann …

OpenSearch ist eine Open-Source-Such- und Analyse-Suite, die von der Community …

Virtuelle Cluster verfügen über einen eigenen API-Server, wodurch sie viel …

Unser Team konfiguriert, verwaltet und integriert die leistungsstarken Lösungen …

Es gibt zum Beispiel VPN, um den Zugang zu den Managed Servern zu sichern, oder …

Von Colocation, Housing, Root- und Cloud-Servern über verwaltete virtuelle und dedizierte Server bis hin zu Container-Lösungen – ganz auf Ihre Bedürfnisse zugeschnitten.

Das Ziel unserer Service Level Agreements (SLAs) ist es, die vereinbarten Leistungen transparent darzustellen und zusätzliche garantierte Leistungen wie kürzere Reaktionszeiten oder Anwendungsüberwachung anzubieten.

Dienste wie VPN, CloudFlare, DDoS-Schutz und Web Application Firewalls schützen nicht nur Ihr gesamtes System, sondern sind auch für die schnelle und zuverlässige Auslieferung Ihrer Website verantwortlich.

Unser Team von über 30 Experten setzt sich dafür ein, die Verfügbarkeit all Ihrer Anwendungen zu gewährleisten. Überlassen Sie uns das Infrastruktur-Management, damit Sie sich auf Ihr Kerngeschäft konzentrieren können.

Wir unterstützten Peak Privacy bei der Konzeption und dem Aufbau einer spezialisierten Serverinfrastruktur für LLM-Inferenz. Der Prozess war von enger …

Mehr erfahren

Wir haben der Renuo AG dabei geholfen, alles, was bisher auf Heroku lief, reibungslos auf Deploio umzustellen, unsere eigene «Platform as a …

Mehr erfahren

Wir haben mühlemann+popp dabei geholfen, die Migration von der Google Cloud zur Nine-Infrastruktur für deren Kunde, ein führendes Schweizer …

Mehr erfahrenHaben Sie Fragen zu unseren Produkten? Kein Problem. Wenden Sie sich an unsere Sales-Abteilung oder gehen Sie direkt ins eigene Cockpit, um alle Möglichkeiten bei Nine zu sehen.